Для чего нужен аудит сайта? Чтобы выявить ошибки, узнать, какие «шестеренки» работают слаженно, а какие нужно добавить или заменить. От правильного функционирования и оптимизации ресурса зависит эффективность его продвижения. Незаметные для глаза простого пользователя недочеты могут серьезно влиять на SEO. Поисковики учитывают все мелочи и, если им что-то не нравится, понижают сайт в выдаче.

В этой статье мы поговорим о том, как провести аудит сайта без помощи специалистов. Вы узнаете, что именно нужно проверять и какие инструменты подойдут для этих целей.

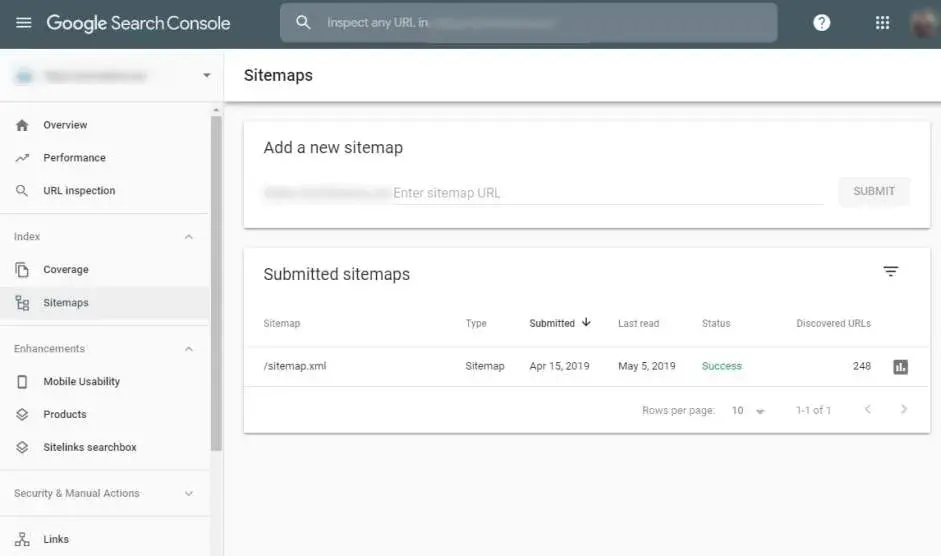

Проверяем карту сайта

Для того, чтобы поисковые системы оперативно индексировали изменения на площадке, нужна карта сайта, которая автоматически обновляется. Ее генерируют при помощи онлайн-сервисов или CMS, а потом загружают в Яндекс. Вебмастер и Google Search Console. На сервисе 1С-UMI карта создается и обновляется автоматически.

Чтобы проверить корректность карты, воспользуйтесь инструментами «Анализ файлов Sitemap» (Яндекс) и «Файлы Sitemap» (Google).

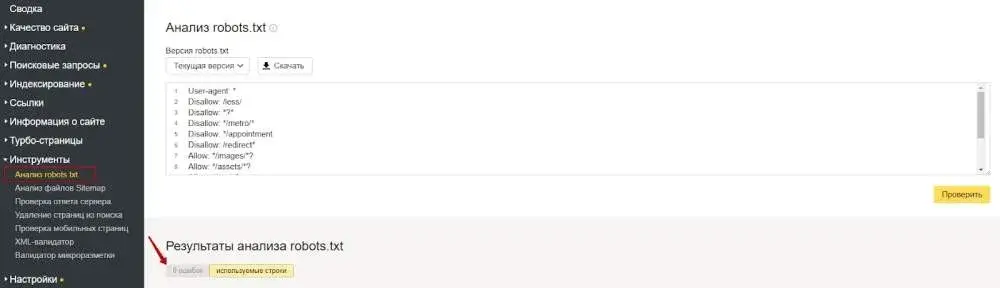

Проверяем файл Robots.txt

Он должен содержать определенные строки и отвечать требованиям поисковиков:

- Требуется подразделение на 3 блока. В одном прописывается юзер-агент для Яндекса, в другом для Google, а в третьем — для всех остальных систем.

- Во всех блоках должен быть прописан путь до Sitemap на сайте.

- Системные и технические страницы или папки на ресурсе должны быть закрыты от индексирования при помощи Disallow. Дополнительно можно закрыть личный кабинет, администраторскую панель, корзину и страницы пагинации.

Проверить Robots.txt на ошибки можно через панель вебмастера от Google и Яндекс.

Эти инструменты располагаются в том же разделе, что и проверка карты сайта.

Редактирование robots.txt для сайтов на сервисе 1С-UMI находится в разделе «Реклама/SEO ―> Файл robots.txt"панели управления сайтом.

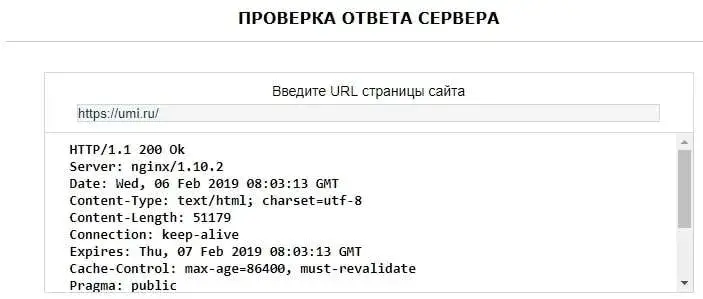

Проверяем ответ сервера

Нормально функционирующие веб-страницы должны отдавать код 200. Несуществующие показывают ошибку 404.

Чтобы проверить, какие страницы работают, а какие перестали существовать, воспользуйтесь онлайн-сервисом MainSpy или программой Netpeak Spider.

Первый позволяет проверить только одну страницу за один раз, второй может проанализировать сразу весь сайт и показать результаты по каждому разделу.

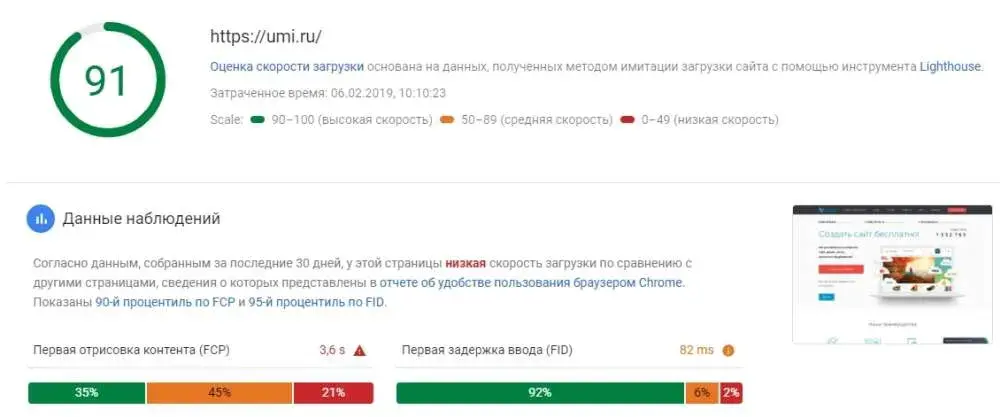

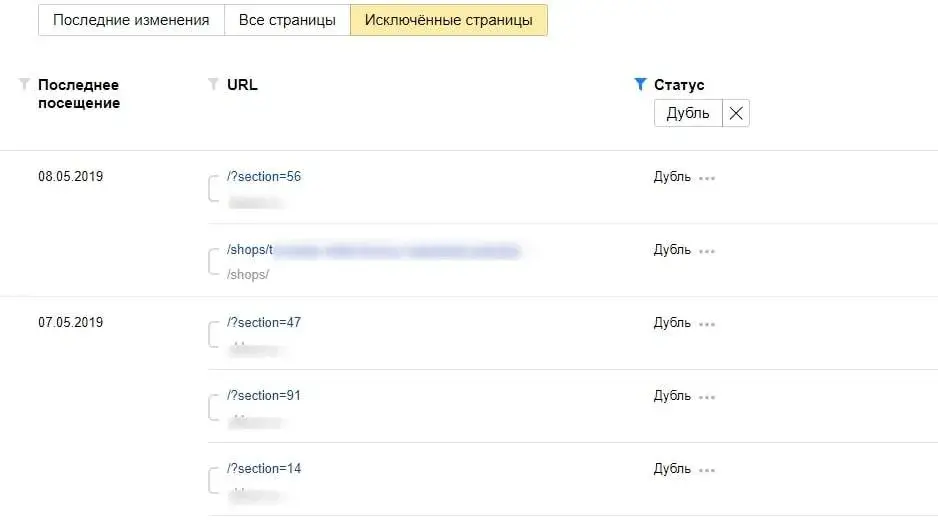

Проверяем скорость загрузки сайта

Как известно, скорость загрузки ресурса влияет на поисковое ранжирование и пользовательские качества сайта. Поисковики вытесняют с верхних позиций своей выдачи те сайты, которые грузятся слишком долго. А люди не ждут загрузки дольше 2–3 секунд и уходят с площадки-тормоза.

Для проверки скорости загрузки вашего сайта воспользуйтесь Google Page Speed. Этот сервис вычисляет, насколько быстро грузится площадка на десктопных и мобильных устройствах, и дает рекомендации по ускорению.

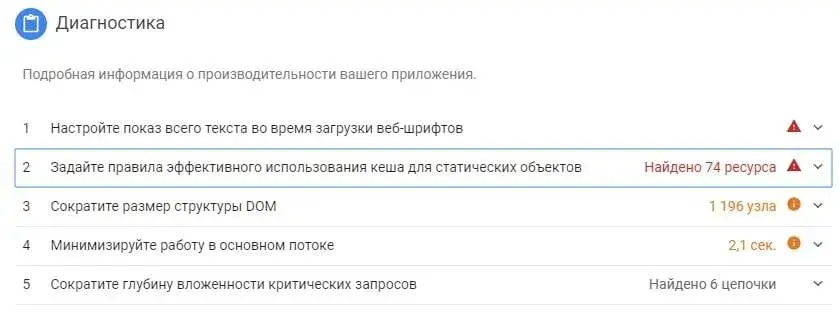

Проверяем микроразметку

Сайт отображается в выдаче поисковых систем правильно, только если его микроразметка корректна. Проверить это можно при помощи инструмента Google Structured Data.

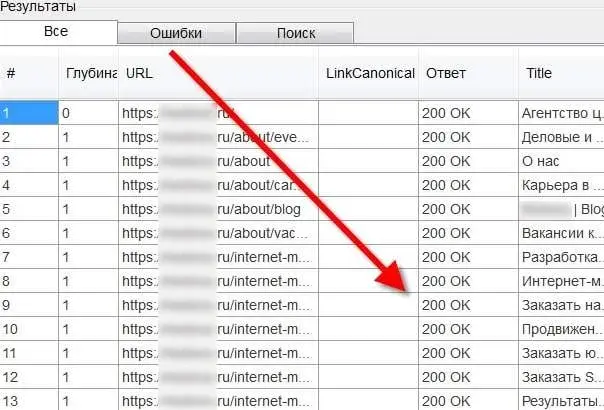

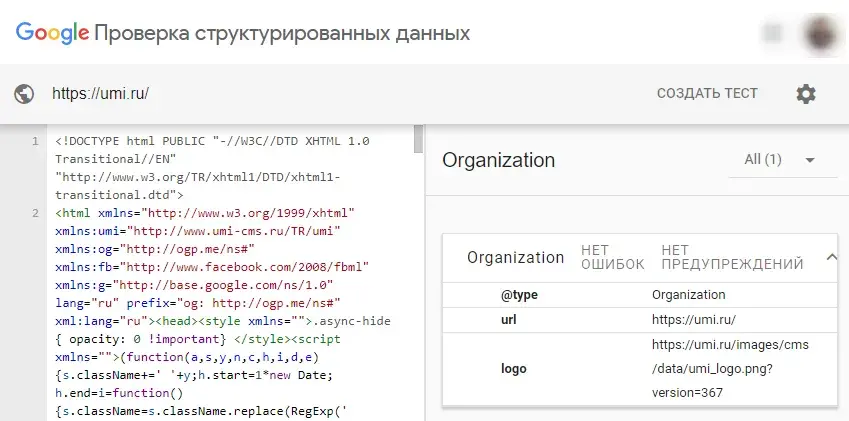

Проверяем на наличие страниц-дублей

Дубли веб-страниц могут появляться из-за множества причин. Например, один и тот же товар присутствует в разных разделах каталога. Или продается в разных цветах, и под каждый цвет создана отдельная карточка товара.

Обнаруживаются дубли при помощи Яндекс. Вебмастер. Для этого авторизуйтесь в данной системе, перейдите в раздел «Индексирование», в подраздел «Страницы в поиске» и откройте вкладку «Исключенные страницы». Тут активируйте фильтр со значением «Дубль». Если на вашем сайте есть дубли, вы их увидите в списке ниже. Если нет, то этот параметр будет неактивен.

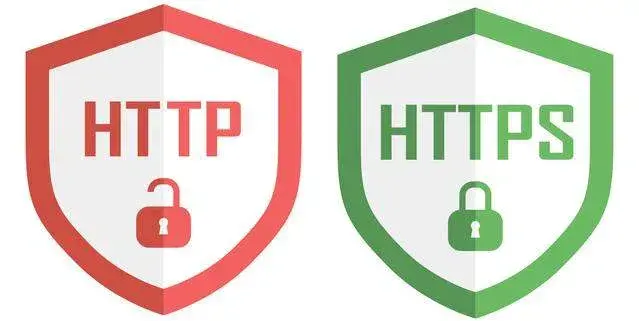

Проверяем протокол безопасности

Речь идет о защищенном HTTPS-протоколе. Он защищает данные пользователей и гарантирует им конфиденциальность.

Поисковики при ранжировании отдают предпочтение сайтам, доступным по HTTPS, и располагают их выше тех, что еще не подключены к безопасному протоколу.

Для проверки не нужны никакие специальные инструменты. Просто зайдите на свой сайт и взгляните, что стоит перед доменным именем. Если HTTPS, то всё в порядке. Если HTTP, то ваш ресурс не использует безопасный протокол, и рекомендуем подключить его.

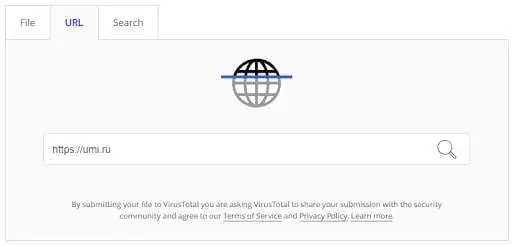

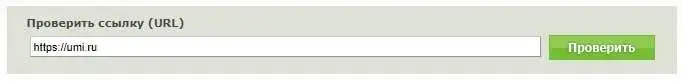

Проверяем сайт на вирусы

Бывает так, что злоумышленник получает доступ к управлению сайтом и размещает вредоносный код. Поисковые системы его видят и помечают как ресурс, который может навредить компьютеру пользователя. Такое оповещение показывается в поисковых результатах и отпугивает посетителей. Из-за этого теряется серьезная часть трафика.

Проверить сайт на наличие вирусов можно при помощи различных инструментов. Например, VirusTotal или Dr. Web. Для этого просто введите адрес своего сайта и нажмите на значок лупы или кнопку «Проверить».

Проверяем контент ресурса

Размещенные на сайте тексты должны быть уникальными для поисковиков. Лучше всего, когда уникальность составляет 100%, но допустимо от 95% (как проверить текст на уникальность?). Объем статей должен составлять минимум 2000 знаков, если вы планируете задействовать SEO-продвижение. Каждый текст необходимо насытить ключевыми словами из расчета 1 запрос на 500 или 1000 знаков.

Для картинок нужно прописать соответствующие теги (Alt и Title). Это делается не только для удобства посетителей, но и для попадания в результаты поиска в Яндексе или Google по картинкам.